什么是 RouteLLM

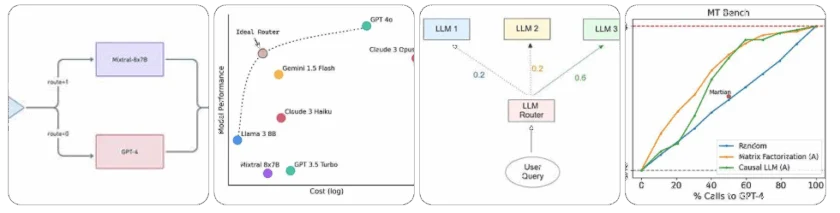

RouteLLM 是由 LM-Sys 和 Anyscale 联合开发的开源框架,旨在优化大型语言模型(LLM)的部署成本与响应质量之间的平衡。通过智能路由机制,RouteLLM 能够根据查询的复杂度,将请求动态地分配给性能与成本最合适的模型,从而在不牺牲质量的前提下显著降低运营成本。

RouteLLM 的功能

RouteLLM 提供了以下核心功能:

- 智能路由:根据查询复杂度,将请求动态分配给性能与成本最合适的模型。

- 成本优化:在保证响应质量的前提下,显著降低运营成本。

- 多模型支持:支持多种 LLM,如 GPT-4、Mixtral-8x7B、Llama 3 等。

- 开源框架:提供完整的代码和文档,支持自定义和扩展。

如何使用 RouteLLM / 快速开始

要开始使用 RouteLLM,请按照以下步骤操作:

- 安装依赖:确保已安装 Python 和相关依赖。

- 配置环境变量:设置 OpenAI 和 Anyscale 的 API 密钥。

- 初始化控制器:使用以下代码初始化 RouteLLM 控制器:

import os

from routellm.controller import Controller

os.environ["OPENAI_API_KEY"] = "your_openai_api_key"

os.environ["ANYSCALE_API_KEY"] = "your_anyscale_api_key"

client = Controller(

routers=["mf"],

strong_model="gpt-4-1106-preview",

weak_model="anyscale/mistralai/Mixtral-8x7B-Instruct-v0.1",

config={

"mf": {

"checkpoint_path": "routellm/mf_gpt4_augmented"

}

},

api_base=None,

api_key=None,

progress_bar=False,

)

有关详细教程,请参阅官方文档。

RouteLLM 的应用场景

RouteLLM 可广泛应用于以下场景:

- 企业级 AI 部署:在大型企业中,使用 RouteLLM 管理多个 LLM,优化成本与性能。

- 聊天机器人:为聊天机器人系统提供智能路由,提高响应效率。

- 内容生成:在内容生成任务中,根据需求选择合适的模型。

RouteLLM 的优势与挑战

优势:

- 成本节约:通过智能路由,显著降低运营成本。

- 高效性能:在保证响应质量的前提下,提高系统效率。

- 灵活扩展:支持多种 LLM,易于与现有系统集成。

挑战:

- 模型选择:需要根据实际需求选择合适的 LLM。

- 配置复杂:初次使用时,可能需要一定的配置和调试。

总结

RouteLLM 是一款功能强大的开源框架,旨在优化 LLM 的部署成本与响应质量之间的平衡。通过智能路由机制,RouteLLM 能够根据查询的复杂度,将请求动态地分配给性能与成本最合适的模型,从而在不牺牲质量的前提下显著降低运营成本。对于需要处理大量文本查询并希望优化成本与性能平衡的开发者和企业,RouteLLM 是一个值得考虑的解决方案。

本文采用 CC BY-NC 4.0 许可协议。商业转载、引用请联系本站获得授权,非商业转载、引用须注明出处。

链接:https://appmark.cn/sites/routellm.html -APPMARK

Inferkit AI 作为模型路由平台,整合 OpenAI 等多种大型语言模型 API。通过降低开发成本和提高可靠性,助力 AI 产品开发。平台配备 playground、教程和 API 密钥管理,支持快速上手。