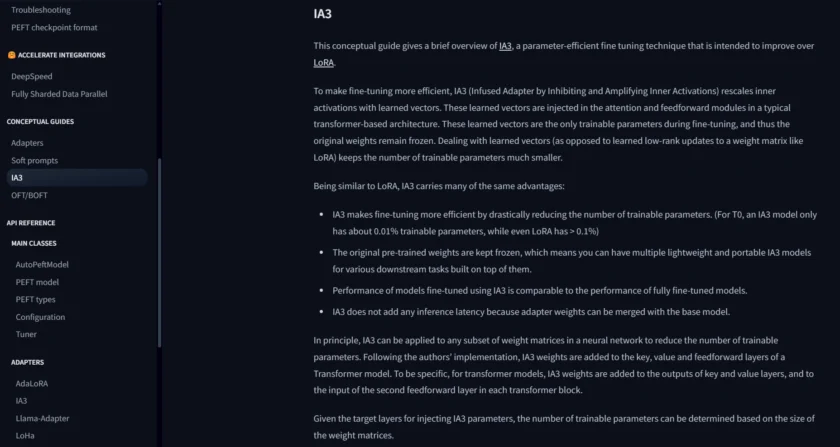

什么是 IA3

IA3,全称为 Infused Adapter by Inhibiting and Amplifying Inner Activations(通过抑制和放大内部激活注入适配器),是一种由 Google 提出的参数高效微调(Parameter-Efficient Fine-Tuning, PEFT)技术。它旨在通过在预训练语言模型的内部激活中引入可学习的缩放因子,从而实现对模型的轻量级适配,以适应各种下游任务。与修改模型权重矩阵的传统微调方法或像 LoRA 那样添加额外参数矩阵的方法不同,IA3 通过直接调整模型在处理信息时的中间状态,实现了高效的知识迁移和任务适应,同时仅引入极少量的可训练参数。

IA3 的功能

IA3 作为一种独特的 PEFT 技术,具有以下关键功能:

- 参数高效性: IA3 通过学习每个 Transformer 层中 key、value 和 feedforward 网络的激活向量的元素级缩放因子(scaling factors),实现了极高的参数效率。相比于动辄数百万甚至数十亿参数的大型语言模型,IA3 引入的可训练参数数量非常少,通常只占原始模型参数的一小部分。

- 直接作用于激活: 与修改模型权重不同,IA3 直接作用于模型的内部激活。这种方法可以更直接地控制模型在处理特定任务时的行为,通过放大关键激活并抑制不相关激活,从而优化模型的性能。

- 易于集成: IA3 作为 Hugging Face PEFT 库的一部分,可以轻松地集成到现有的基于 Transformers 库的机器学习工作流程中。开发者可以利用 PEFT 库提供的 API,快速地将 IA3 应用到各种预训练模型上。

- 良好的性能表现: 尽管 IA3 引入的参数量很少,但在许多自然语言处理任务上,它仍然能够取得与全参数微调或其它更复杂的 PEFT 方法相媲美的性能。这使得 IA3 成为在计算资源有限的情况下进行模型微调的理想选择。

- 支持多种 Transformer 架构: IA3 的概念可以应用于各种基于 Transformer 架构的预训练模型,包括但不限于 BERT、RoBERTa、GPT 等。

- 灵活性: IA3 允许开发者针对模型中的不同组件(例如 self-attention 的 key 和 value 激活,以及 feedforward 网络的激活)独立地学习缩放因子,从而提供了更细粒度的控制。

如何使用/快速开始

要在 Hugging Face PEFT 库中使用 IA3,您可以按照以下步骤进行操作:

- 安装 PEFT 库: 确保您已经安装了 Hugging Face 的 PEFT 库和 Transformers 库。如果尚未安装,可以使用 pip 进行安装:

pip install peft transformers - 加载预训练模型: 使用 Transformers 库加载您想要微调的预训练模型。例如:

from transformers import AutoModelForSequenceClassification model_name_or_path = "bert-base-uncased" model = AutoModelForSequenceClassification.from_pretrained(model_name_or_path) - 配置 IA3: 从 PEFT 库导入

IA3Config并进行配置。您可以指定要应用 IA3 的模块类型(通常是"all"),以及其他相关参数(如果需要)。from peft import IA3Config, get_peft_model ia3_config = IA3Config(target_modules=["down_proj", "up_proj", "q_proj", "v_proj"]) # 针对特定层进行配置 # 或者,如果想应用于所有可应用层,可以使用 target_modules="all" model = get_peft_model(model, ia3_config)请注意,

target_modules需要根据您使用的具体模型架构进行调整。对于不同的模型,需要查看其内部结构以确定关键的激活层名称。 - 准备数据和训练: 像使用其他 PEFT 方法一样,准备您的训练数据,并使用 Hugging Face 的

Trainer类或您自己的训练循环来微调模型。 - 保存和加载 IA3 适配器: 微调完成后,可以使用

trainer.save_model()方法保存 IA3 适配器的权重。之后,可以使用PeftModel.from_pretrained()方法加载已保存的 IA3 适配器到原始模型上。

通过这些步骤,您就可以利用 IA3 技术对预训练语言模型进行高效的微调。由于 IA3 引入的参数量非常少,因此它特别适合在资源有限的环境下进行模型适配。建议查阅 Hugging Face PEFT 库的官方文档和示例代码,以获取更详细的使用说明和针对不同模型架构的配置方法。

本文采用 CC BY-NC 4.0 许可协议。商业转载、引用请联系本站获得授权,非商业转载、引用须注明出处。

链接:https://appmark.cn/sites/ia3.html -APPMARK

Unsloth AI 是一个开源 Python 库,旨在通过优化的 GPU 内核和低内存技术,显著加速和优化大型语言模型(LLMs)的微调过程。它支持多种流行的 LLM 架构和微调方法,能够帮助开发者在资源有限的环境下高效地定制和优化 AI 模型。