什么是 Layoutlmv3

Layoutlmv3 是微软 UNILM (Unified Language Model) 项目下的一个先进的文档智能基础模型。它是一种多模态 Transformer 模型,专门为理解和处理包含文本和图像的文档而设计。Layoutlmv3 的核心创新在于其统一的文本和图像掩码预训练方法,以及词-图像块对齐(Word-Patch Alignment)的目标。通过这种统一的架构和训练方式,Layoutlmv3 不仅在文本相关的文档任务(如表单理解、票据理解、文档视觉问答)上表现出色,也在图像相关的任务(如文档图像分类和文档布局分析)上取得了领先的性能。作为 LayoutLM 和 LayoutLMv2 的继任者,Layoutlmv3 进一步提升了模型在文档人工智能领域的通用性和有效性。

Layoutlmv3 的功能

Layoutlmv3 具备以下关键功能,使其成为文档人工智能领域的强大工具:

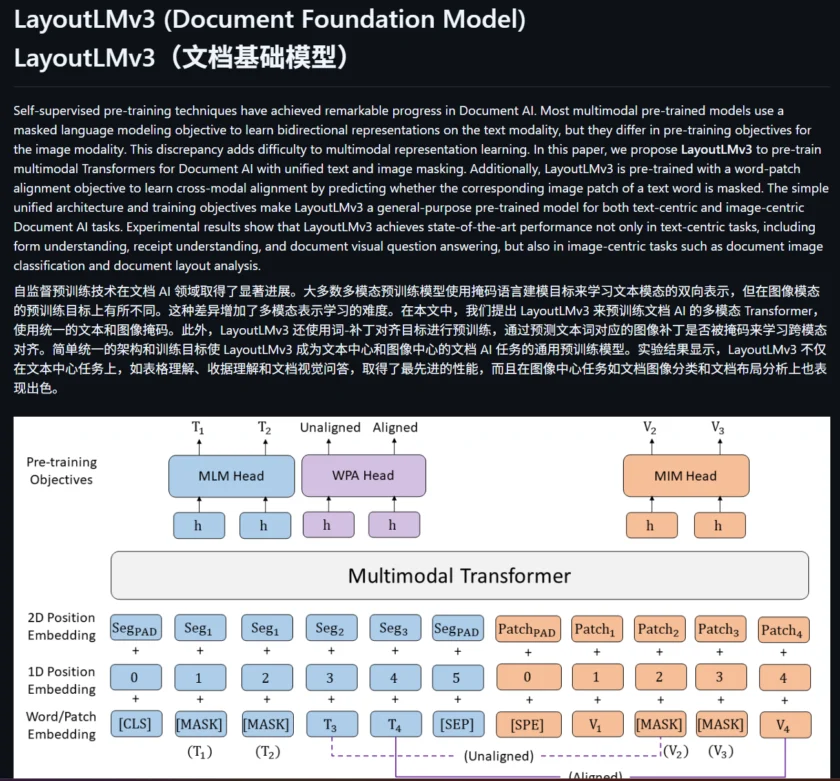

- 统一的文本和图像掩码预训练: Layoutlmv3 采用了统一的掩码语言建模(Masked Language Modeling, MLM)和掩码图像建模(Masked Image Modeling, MIM)作为预训练目标。这种统一的方法简化了模型架构,并有助于学习更一致的多模态表示。

- 词-图像块对齐(Word-Patch Alignment): 除了 MLM 和 MIM,Layoutlmv3 还引入了词-图像块对齐(WPA)目标。该目标旨在通过预测文本单词对应的图像块是否被掩盖来学习跨模态的对齐,从而增强模型对文本和图像之间关系的理解。

- 强大的多模态 Transformer 架构: Layoutlmv3 基于 Transformer 架构,能够有效地处理文本、布局和视觉信息。它使用图像块嵌入(patch embeddings),类似于 Vision Transformer (ViT),而不是像之前的 LayoutLM 模型那样依赖 CNN 作为视觉特征提取的骨干网络,从而简化了模型结构并减少了参数量。

- 广泛的应用场景: Layoutlmv3 作为一个通用的预训练模型,可以应用于多种文档人工智能任务,包括:

- 表单理解 (Form Understanding): 例如,从扫描的表单中提取关键信息。

- 票据理解 (Receipt Understanding): 例如,从收据中提取日期、金额和商品信息。

- 文档视觉问答 (Document Visual Question Answering, DocVQA): 例如,回答关于文档内容和布局的问题。

- 文档图像分类 (Document Image Classification): 例如,将文档图像分类到不同的类别。

- 文档布局分析 (Document Layout Analysis): 例如,识别文档中的不同区域,如文本、标题、列表、表格和图像。

- 预训练模型和易于微调: 微软提供了基于不同规模数据集预训练的 Layoutlmv3 模型,可以直接用于下游任务的微调,从而减少了从头开始训练模型的需求。

- 支持中文等多种语言: 微软也发布了针对中文文档预训练的 Layoutlmv3 模型,使其能够更好地处理中文文档相关的任务。

如何使用/快速开始

要开始使用 Layoutlmv3,您可以按照以下步骤进行操作:

- 环境准备:

- 确保您的系统安装了 Python 3.7 或更高版本。

- 推荐使用 Anaconda 创建一个独立的 Python 环境:

conda create --name layoutlmv3 python=3.7 conda activate layoutlmv3

- 克隆代码仓库: 克隆 Microsoft UNILM 的 GitHub 仓库到您的本地机器:

git clone https://github.com/microsoft/unilm.git然后进入 Layoutlmv3 目录:

cd unilm/layoutlmv3 - 安装依赖: 安装项目所需的依赖包:

pip install -r requirements.txt您可能需要根据您的硬件配置安装 PyTorch 和 torchvision。请参考 PyTorch 官网获取适合您系统的安装命令。例如:

pip install torch==1.10.0+cu111 torchvision==0.11.2+cu111 -f https://download.pytorch.org/whl/torch_stable.html(请将

cu111替换为您实际的 CUDA 版本,或者选择安装 CPU 版本。) - 获取预训练模型: 您可以从 Hugging Face Model Hub 上找到微软提供的 Layoutlmv3 预训练模型,例如

microsoft/layoutlmv3-base、microsoft/layoutlmv3-large和microsoft/layoutlmv3-base-chinese。您可以选择合适的模型进行下载或直接使用 Transformers 库加载。 - 使用 Transformers 库(推荐): Hugging Face 的 Transformers 库提供了对 Layoutlmv3 的便捷支持。您可以直接使用

LayoutLMv3Processor和LayoutLMv3ForDocumentClassification等类来加载预训练模型并进行推理或微调。以下是一个简单的示例:from transformers import LayoutLMv3Processor, LayoutLMv3ForDocumentClassification from PIL import Image # 加载预训练的处理器和模型 processor = LayoutLMv3Processor.from_pretrained("microsoft/layoutlmv3-base") model = LayoutLMv3ForDocumentClassification.from_pretrained("microsoft/layoutlmv3-base") # 加载图像 image = Image.open("your_document_image.png").convert("RGB") words = ["example", "words", "here"] # 实际应用中需要从文档中提取单词 boxes = [[0, 0, 10, 5], [10, 0, 20, 5], [0, 5, 15, 10]] # 实际应用中需要获取单词的边界框 # 准备输入 inputs = processor(images=image, words=words, boxes=boxes, return_tensors="pt") # 进行推理 outputs = model(**inputs) logits = outputs.logits predicted_class_idx = logits.argmax(-1).item() print("Predicted class:", model.config.id2label[predicted_class_idx]) - 微调示例: 在

layoutlmv3/examples目录下提供了针对不同任务的微调示例,例如目标检测。您可以参考这些示例来了解如何针对特定任务微调 Layoutlmv3 模型。

通过以上步骤,您可以开始探索和使用 Layoutlmv3 模型来解决您的文档智能问题。建议您查阅 GitHub 仓库中的 README 文件和 Hugging Face Transformers 库的文档,以获取更详细的使用说明和高级特性。

本文采用 CC BY-NC 4.0 许可协议。商业转载、引用请联系本站获得授权,非商业转载、引用须注明出处。

链接:https://appmark.cn/sites/microsot-unilm-layoutlmv3.html -APPMARK

EasyOCR 是一个基于 Python 的即用型 OCR 库,支持超过 80 种语言和多种书写脚本。它基于 PyTorch 框架,提供了简单易用的 API,能够高效准确地从图像中提取文本,适用于各种 OCR 任务。