什么是 LLM-App

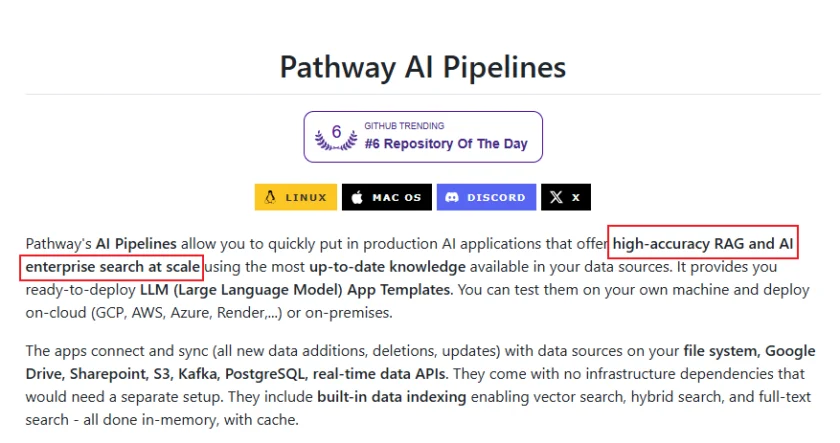

LLM-App 是一个由 Pathway.com 开发的开源框架,旨在帮助开发者构建实时的、由大型语言模型(LLMs)驱动的应用程序。在当今数据驱动的世界中,实时性对于许多应用至关重要。LLM-App 的出现正是为了满足这一需求,它提供了一套工具和架构,使得开发者能够以低延迟和高吞吐量的方式将 LLMs 集成到他们的实时数据处理流程中。与传统的批处理或离线处理方式不同,LLM-App 允许应用程序在数据产生的同时进行智能分析和响应,从而为用户带来更及时、更具交互性的体验。无论是构建实时的智能客服、动态内容推荐系统,还是实时的欺诈检测系统,LLM-App 都能够提供强大的支持。其核心理念是将 LLMs 的强大自然语言理解和生成能力与实时数据流处理技术相结合,从而开启了构建新一代智能应用的无限可能。作为一个开源项目,LLM-App 鼓励社区参与和贡献,不断完善和扩展其功能,以适应快速发展的 LLM 技术和不断涌现的应用场景。

LLM-App 的功能

LLM-App 提供了多种关键功能,使其成为构建实时 LLM 应用的强大工具:

- 实时数据流处理: LLM-App 的核心是其强大的实时数据流处理能力。它可以高效地处理源源不断的数据,并将其输送给集成的 LLM 进行分析和处理。

- 低延迟: 框架的设计注重低延迟,确保应用程序能够快速响应实时数据,并及时生成结果。这对于需要即时反馈的应用至关重要。

- 高吞吐量: LLM-App 能够处理高并发的数据流,保证应用程序在面对大量实时数据时依然能够稳定运行。

- 灵活的 LLM 集成: 该框架支持与各种流行的 LLMs 进行集成,包括 OpenAI 的 GPT 系列、Hugging Face 的 Transformers 等。开发者可以根据自己的需求和偏好选择合适的 LLM。

- 易于使用的 API: LLM-App 提供了简洁且易于使用的 Python API,使得开发者能够快速上手并构建复杂的实时 LLM 应用。

- 可扩展性: 框架的架构设计考虑了可扩展性,可以轻松地部署和扩展到不同的基础设施上,以应对不断增长的数据量和用户需求。

- 内置的连接器: LLM-App 提供了多种内置的连接器,用于连接各种数据源和数据接收器,例如 Kafka、数据库、API 端点等,方便开发者构建完整的数据处理管道。

- 支持多种应用场景: 无论是文本生成、语义搜索、情感分析,还是更复杂的实时决策支持系统,LLM-App 都能够提供强大的支持。

如何使用/快速开始

要快速开始使用 LLM-App,您可以按照以下步骤进行操作:

- 安装 LLM-App: 首先,您需要安装 LLM-App 库。可以使用 pip 命令进行安装:

pip install pathway-llm - 导入必要的模块: 在您的 Python 代码中,导入

pathway和pathway.llms等必要的模块。 - 配置数据源: 定义您的实时数据源。LLM-App 支持多种数据源连接器。例如,您可以从 Kafka 主题读取数据。

- 集成 LLM: 选择并配置您想要使用的 LLM。例如,如果您想使用 OpenAI 的 GPT-3,您需要设置 API 密钥。LLM-App 提供了方便的接口来集成不同的 LLM 服务。

- 定义数据处理逻辑: 使用 Pathway 提供的 API 定义您的数据处理逻辑,包括如何将实时数据输入到 LLM,以及如何处理 LLM 的输出。

- 运行应用程序: 使用 Pathway 提供的运行机制启动您的实时 LLM 应用程序。

以下是一个简单的示例代码片段,展示了如何使用 LLM-App 从一个虚拟的数据源读取数据,并使用 OpenAI 的 GPT-3 模型进行处理:

import pathway as pw

from pathway.llms import openai

# 定义一个虚拟的实时数据源

@pw.io.input("input_topic")

def input_data():

while True:

yield {"text": "Translate 'Hello world' to French."}

yield {"text": "Summarize the following article: ..."}

# 实际应用中,这里会连接到真实的数据源

# 配置 OpenAI 模型

openai_model = openai.OpenAIChat(

api_key=pw.Secret("OPENAI_API_KEY"),

model_name="gpt-3.5-turbo",

)

# 定义数据处理逻辑:将输入文本发送给 OpenAI 模型并获取结果

processed_data = input_data().select(

result=openai_model(prompt=pw.this.text)

)

# 定义数据输出

@pw.io.output("output_topic")

def output_data(data: pw.typing.Table):

for row in data:

print(f"Input: {row['text']}, Output: {row['result']}")

# 运行应用程序

pw.run(processed_data, output_data)

这个示例只是一个入门。LLM-App 的强大之处在于其灵活性和可扩展性。您可以根据自己的具体需求构建各种复杂的实时 LLM 应用程序。建议您查阅 LLM-App 的 GitHub 仓库 获取更详细的文档和示例。

本文采用 CC BY-NC 4.0 许可协议。商业转载、引用请联系本站获得授权,非商业转载、引用须注明出处。

链接:https://appmark.cn/sites/llm-app.html -APPMARK

AutoRAG 是一个开源框架,旨在自动化检索增强生成(RAG)流程。它提供数据准备、检索器选择、生成模型集成、自动评估与优化等功能,帮助开发者高效构建和部署 RAG 系统,适用于智能客服、知识问答、内容创作等多种场景。